生成式AI跨越图灵测试之后,机器人将会变得多聪明?

图灵测试曾经是证明机器智能的黄金标准。这一代机器人正在超越它。

在Claes de Graaff看来,Franz Broseph似乎像任何其他外交游戏玩家。手柄是一个笑话——奥地利皇帝弗朗茨·约瑟夫一世重生为在线兄弟——但那是玩外交的人往往喜欢的那种幽默。该游戏是经典游戏,深受约翰·F·肯尼迪和亨利·基辛格等人的喜爱,在重现第一次世界大战时将军事战略与政治阴谋相结合:玩家在计划军队如何穿越20世纪欧洲时与盟友、敌人和介于两者之间的每个人进行谈判。

当Franz Broseph在8月底参加一个由20人组成的在线锦标赛时,他向其他玩家求爱,对他们撒谎,并最终背叛了他们。他以第一名完赛。

居住在荷兰的化学家de Graaff先生获得第五名。他花了近10年的时间在网上和全球面对面的锦标赛上玩外交游戏。直到几周后才意识到他输给了一台机器。Franz Broseph是个机器人!

“我惊呆了,”36岁的de Graaff先生说。“这看起来是如此真实——如此栩栩如生。它可以阅读我的文本,与我交谈,并制定互利的计划——这将使我们双方都能取得成功。它还欺骗了我,背叛了我,就像顶级玩家经常做的那样。”

Franz Broseph由科技巨头Meta、麻省理工学院和其他著名大学的人工智能研究人员团队构建,是快速将机器智能推向新领域的新一波在线聊天机器人之一。

当你和这些机器人聊天时,感觉就像在和另一个人聊天。换句话说,它可能会感觉机器已经通过了本应证明其智能的测试。

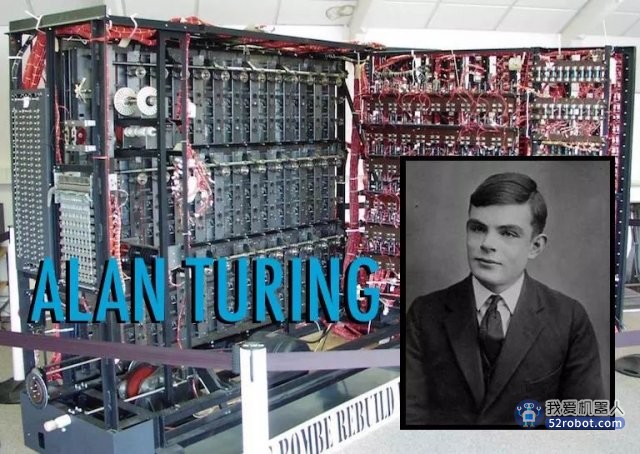

Alan Turing, a British mathematician, proposed in 1950 that the test of machine intelligence would be an ability to conduct a conversation in an indistinguishably human way.Credit...Archivio GBB, via Alamy

70多年来,计算机科学家一直在努力构建可能通过图灵测试的技术:我们人类不再确定我们是在与机器还是与人聊天的技术拐点。该测试以著名的英国数学家、哲学家和战时密码破解者艾伦·图灵命名,他早在1950年就提出了该测试。他认为,当机器最终达到真正的智能时,它可以向世界展示。

图灵测试是一种主观测量。这取决于提问的人是否确信自己正在与他人交谈,而实际上他们正在与一个装置交谈。

但无论谁问问题,机器很快就会把这个测试留在后视镜里。

像Franz Broseph这样的机器人已经在特定情况下通过了测试,例如谈判外交行动或致电餐厅预订晚餐。ChatGPT是旧金山实验室OpenAI于11月发布的机器人,让人们感觉自己好像在和另一个人聊天,而不是机器人。实验室表示,有100多万人使用过它。由于ChatGPT几乎可以写任何东西,包括学期论文,大学担心这会嘲弄课堂作业。当有些人与这些机器人交谈时,他们甚至将它们描述为有知觉或有意识的,认为机器以某种方式形成了对周围世界的意识。

在私下里,OpenAI构建了一个系统GPT-4,该系统甚至比ChatGPT更强大。它甚至可以生成图像和单词。

然而,这些机器人没有知觉。它们没有意识。它们并不聪明——至少不是人类聪明的方式。即使是开发这项技术的人也承认这一点。

这些机器人非常擅长某些类型的对话,但它们无法像大多数人那样对意想不到的事情做出反应。它们有时会胡说八道,无法纠正自己的错误。虽然它们在某些方面可以匹配甚至超过人类的表现,但在另一些方面则不能。与之前的类似系统一样,它们倾向于补充而不是取代熟练工人。

部分问题是,当机器人模拟对话时,它似乎比实际情况更聪明。当我们在宠物或机器中看到类似人类的行为的闪光时,我们倾向于认为它的行为也以其他方式与我们相似——即使它不是。图灵测试没有考虑到我们人类天生容易上当受骗,语言很容易误导我们相信一些不真实的东西。

OpenAI的崛起

旧金山公司是世界上最雄心勃勃的人工智能实验室之一。以下是一些最近的事态发展...

ChatGPT:尖端的聊天机器人引起了人们对学生在家庭作业上作弊的恐惧。但我们的技术专栏作家写道,它作为教育工具的潜力大于其风险。

DALL-E 2:该系统允许您通过描述您想要看到的内容来创建数字图像。但对一些人来说,图像生成器令人担忧。

GPT-3:自然语言系统具有令人难以置信的流利性,可以编写、辩论和编码。对未来的影响可能是深远的。

OpenAI首席科学家、过去十年最重要的人工智能研究人员之一Ilya Sutskever在谈到新一波聊天机器人时说:“这些系统可以做很多有用的事情。”“另一方面,它们还没有发展到那一步,即象人们认为的那样它们可以做他们做不到的事情。”

随着研究实验室的最新技术的出现,现在很明显——如果以前不是很明显的话——科学家必须重新思考和重塑他们如何跟踪人工智能的进展——图灵测试已无法胜任这项任务。

人工智能技术一次又一次地超越了被认为无法克服的测试,包括掌握国际象棋(1997年)、“危险!(Jeopardy!)”(2011年)、围棋(2016年)和扑克(2019年)。现在它正在超越另一个目标,再说一遍,这并不一定意味着我们所想象的那样。

我们——公众——需要一个新的框架来了解人工智能可以做什么,它不能做什么,它将来会做什么,以及它将如何改变我们的生活,无论是好是坏。

模仿游戏

The 2014 film “The Imitation Game,” which depicts Turing’s successful attempt to crack the German Enigma code during World War II, starred Benedict Cumberbatch. Credit...Jack English/Weinstein Company

1950年,艾伦·图灵发表了一篇名为《计算机与智能》的论文。在他的想法帮助催生了世界上第一批计算机十五年后,他提出了一种方法来确定这些新机器是否可以思考。当时,科学界正在努力理解什么是计算机。它是数字大脑吗?还是别的东西?图灵提供了一种回答这个问题的方法。

他称之为“模仿游戏”。

它涉及两次冗长的对话——一次与机器,另一次与人类对话。这两个对话都将通过文本聊天进行,这样另一端的人就不会立即知道他或她正在与哪个对话。如果随着对话的进展,这个人无法分辨出两者之间的区别,那么你可以正确地说机器可以思考。

图灵写道:“问答方法似乎适合介绍我们希望包括的人类努力的几乎任何一个领域。”他解释说,该测试可以包括从诗歌到数学的一切,并提出了一个假设的对话:

问:请给我写一首关于福斯桥主题的十四行诗。

A:把这个算在外。我从来不会写诗。

问:将34957添加到70764。

答:(暂停大约30秒,然后给出答案)105621。

问:你会下棋吗?

A:是的。

问:我的K1有K,没有其他部件。你在K6只有K,在R1只有R。这是你的举动。你在玩什么?

答:(停顿15秒后)R-R8伴侣。

当图灵提出测试时,计算机无法聊天。科学家通过打字机、磁带和穿孔卡将数学和文本指令输入真空管,与这些房间大小的机器进行通信。但随着岁月的流逝,研究人员创造了一个他们称之为人工智能的新领域——一种协同努力,以构建可以在人类水平上思考的机器——许多人将模仿游戏作为最终目标。

“人们没有建立流利对话的系统。这太难了,”哈佛大学计算机科学家Stuart Shieber说,他专门研究计算语言学,包括图灵测试。“但这是一种愿望。”

到20世纪60年代中期,机器可以以小规模的方式聊天。即便如此,他们还是愚弄了人们,让他们相信自己比实际上的更聪明。

Joseph Weizenbaum, a professor at M.I.T., invented the natural language program Eliza in the 1960s. Credit...Calvin Campbell/Massachusetts Institute of Tech.

当时,麻省理工学院的研究员Joseph Weizenbaum建立了一个名为Eliza的自动心理治疗师,它只不过是重复用户以问题形式说的话。但有些人把这个机器人当成人类治疗师,向她倾诉他们最私人的秘密和感受。

在接下来的几十年里,聊天机器人以蜗牛般的速度进步。研究人员所能做的最好的事情就是列出一长串规则,定义机器人应该如何行为。无论他们写了多少规则,它们永远都不够。自然语言的范围太大了。

2014年,经过近60年的人工智能研究,圣彼得堡的三名研究人员俄罗斯彼得堡建造了一个名为Eugene Goostman的机器人,模仿了一位学习英语作为第二语言的13岁乌克兰人。其创作者和新闻媒体声称它通过了图灵测试,但这被大大夸大了。

当被问及“哪个更大,鞋盒还是珠穆朗玛峰?”时,这个机器人说:“我现在无法做出选择。”当被问及“一头骆驼有多少条腿?”时,它回答说:“在2到4条之间。也许,三个?:-)))”

然后,大约三年后,谷歌和OpenAI等地的研究人员开始构建一种新的人工智能。

给我写一首十四行诗

最近的一个早上,我问了ChatGPT与图灵在1950年的论文中提出的问题相同。它立即产生了一首关于福斯桥(Forth Bridge,苏格兰福斯河上的悬臂式大桥)的诗:

它的红色油漆在早晨的阳光下闪闪发光

值得一看的景象,让所有人都能看到

它的威严和宏伟从未完成

然后它正确地添加了34,957和70,764。它不需要30秒就能做到这一点。当我像图灵一样布置国际象棋比赛的结尾时,它以通常清晰、简洁、自信的散文回应。它似乎理解了这种情况。

但事实并非如此。它把游戏的结尾误认为是开头。“我会把车搬到R2,”它说。“在国际象棋中尽快发动你的棋子(将它们从起始位置移动)通常是一个好主意。”

ChatGPT是研究人员所说的神经网络,这是一个松散地模仿大脑神经元网络的数学系统。这是在谷歌翻译等服务上翻译英语和西班牙语的相同技术,还可以为在城市街道上穿行的自动驾驶汽车识别行人。

神经网络通过分析数据来学习技能。例如,通过精确定位数千张停车标志照片中的模式,它可以学会识别停车标志。

五年前,谷歌、OpenAI和其他人工智能实验室开始设计神经网络,分析大量数字文本,包括书籍、新闻报道、维基百科文章和在线聊天日志。研究人员称它们为“大型语言模型”。这些系统在人们连接单词、字母和符号的方式中精确定位了数十亿种不同的模式,进而学会了生成自己的文本。

他们可以创建推文、博客文章、诗歌,甚至计算机程序。他们可以进行对话——至少在某种程度上。当他们这样做时,他们可以无缝地组合遥远的概念。你可以要求他们重写女王的流行轻歌剧《波希米亚狂想曲》,这样它就会对博士后学术研究人员的生活进行狂想,他们会的。

伦敦实验室DeepMind深度学习研究高级总监Oriol Vinyals说:“他们可以推断。”他建立了突破性的系统,可以兼顾从语言到三维电子游戏的一切。“他们可以以你从未预料到的方式组合概念。”

研究人员、企业和其他早期采用者多年来一直在测试这些系统。最初,它们很难使用。他们吐出和连贯语言一样多的废话。但有了ChatGPT,OpenAI完善了这项技术。

当人们测试该系统的早期版本时,OpenAI要求他们对其响应进行评分,具体说明它们是令人信服、真实还是有用。然后,通过一种称为强化学习的技术,实验室使用这些评级来磨练系统,并更仔细地定义它会做什么和不做什么。

结果是一个旨在回答个别问题的聊天机器人——这正是图灵所设想的。谷歌、Meta和其他组织已经构建了以类似方式运行的机器人。

问题是,虽然他们的语言技能令人印象深刻,但单词和想法并不总是得到大多数人所谓的理性或常识的支持。这些系统编写食谱时不考虑食物的味道。他们几乎没有区分事实和虚构。即使他们不了解游戏状态,他们也建议完全自信地下棋。

因为他们接受过来自互联网的数据培训,在很多情况下,他们似乎把事情做对了,而实际上却弄错了。

博士OpenAI的Sutskever将这些机器人与特斯拉称之为全自动驾驶的自动驾驶服务进行了比较。这项实验技术可以在城市街道上自行行驶。但你——人类司机——需要随时关注道路并控制汽车。

“它什么都做。它转过身来,停了下来,看到了所有的行人,”他说。“然而,你必须相当频繁地干预。”

ChatGPT确实进行问答,但当你把它带到其他方向时,它往往会崩溃。Franz Broseph可以进行几分钟的外交谈判活动,但如果每轮谈判都稍长一点,De Graaff先生很可能会意识到这是一个机器人。如果Franz Broseph陷入任何其他状况——例如接听技术支持电话——那将是毫无用处的。

一个新的测试

在发布聊天机器人六个月之前,OpenAI推出了一个名为DALL-E的工具。

这是对2008年关于自动机器人的动画电影《机器人总动员》(WALL-E)和超现实主义画家萨尔瓦多(Salvador Dalí)的致敬,这项实验性技术可以让你简单地描述你想看到的东西,就能创建数字图像。这也是一个神经网络,很像Franz Broseph或ChatGPT。区别在于它同时从图像和文本中学习。通过分析数以百万计的数字图像和描述它们的说明文字,它学会了识别图片和文字之间的联系。

这就是所谓的多模态系统。谷歌、OpenAI和其他机构已经在使用类似的方法来构建可以生成人和物体视频的系统。初创企业正在开发能够代用户浏览器软件应用程序和网站的机器人。

这些系统不是任何人都能用图灵测试或其他简单方法正确评估的。他们的最终目标不是对话。

由谷歌母公司拥有的谷歌和DeepMind的研究人员正在开发测试,旨在评估聊天机器人和像DALL-E这样的系统,以判断它们哪些方面做得好,哪里缺乏理性和常识,等等。一项测试向人工智能系统显示视频,并要求他们解释发生了什么。例如,在看到有人摆弄电动剃须刀后,人工智能必须解释剃须刀没有打开的原因。

这些测试感觉像是学术练习——很像图灵测试。而我们需要一些更实际的东西,能够真正告诉我们这些系统擅长什么,不能做什么,它们将如何在短期内取代人类劳动,以及如何不能。

我们也可以改变态度。华盛顿大学名誉教授、西雅图著名实验室艾伦人工智能研究所创始首席执行官Oren Etzioni说:“我们需要一个范式转变——我们不再通过将机器与人类行为进行比较来判断智力。”

图灵的测试判断了机器是否可以模仿人类。这就是人工智能通常被描绘成像人一样思考的机器的崛起。但今天正在开发的技术与你和我大不相同。他们无法处理他们从未见过的概念。他们不能在物理世界中接受想法并探索它们。

ChatGPT明确了这一点。随着越来越多的用户尝试它,他们展示了它的能力和局限性。一位Twitter用户问ChatGPT在O T T F F S S序列中接下来是哪个字母,它给出了正确的答案(E)。但它也告诉他正确的不能正确回答的原因,没有意识到这些字母是数字1到8中的首批字母。

与此同时,这些机器人在很多方面优于你和我。他们不会累。他们不会让情绪笼罩他们试图做的事情。他们可以立即利用大量信息。它们可以以人类永远无法企及的速度和体积生成文本、图像和其他媒体。

未来可期

在未来几年里,它们的技能也将大大提高。

研究人员可以通过向这些系统提供越来越多的数据来快速磨练这些系统。最先进的系统,如ChatGPT,需要几个月的培训,但在这几个月里,它们可以发展出过去没有呈现的技能。

DeepMind研究和机器人高级总监赖亚•哈德塞尔(Raia Hadsell)表示:“我们已经找到了一套可以轻松扩展的技术。”“我们有一个简单而强大的方法,它会越来越好。”

过去几年我们在这些聊天机器人上看到的指数级改进不会永远持续下去。收益可能很快就会趋于平稳。但即便如此,多模态系统仍将继续改进,并掌握越来越复杂的技能,包括图像、声音和计算机代码。计算机科学家将把这些机器人与能做它们不能做的事情的系统结合起来。尽管ChatGPT没有通过图灵的象棋测试,但我们在1997年就知道,计算机可以在国际象棋上击败人类高手。将ChatGPT插入国际象棋程序,这个漏洞就被填补了。

在未来几个月和几年里,这些机器人将帮助你在互联网上找到信息。他们将以你能理解的方式解释概念。如果你愿意,他们甚至会写你的推文、博客文章和学期论文。

他们会在你的电子表格中列出你的每月支出。他们将访问房地产网站,并在你给初的价格范围内找到房屋。他们将制作看起来像人类的在线头像。他们将制作迷你电影,包括音乐和对话。

Salesforce的前首席研究科学家Bryan McCann说:“这将是皮克斯的下一步——任何人都可以非常快速创作的超个性化电影。”他正在一家名为You.com的初创公司探索聊天机器人和其他人工智能技术。

正如ChatGPT和DALL-E所表明的那样,这种事情将是令人震惊、迷人和有趣的。它还会让我们想知道它将如何改变我们的生活。那些一生都在制作电影的人会怎么样?这项技术会用看起来真实但其实不真实的图像淹没互联网吗?他们的错误会让我们误入歧途吗?

卡尔·伯恩斯坦(Carl Bernstein)和鲍勃·伍德沃德(Bob Woodward)关于揭露水门事件的经典故事《All the President’s Men》讲述了伍德沃德在耶鲁大学读大一时写的一篇历史论文。在阅读了无数关于亨利四世(King Henry IV)在1077年赤脚站在雪地里等待格雷戈里教皇(Pope Gregory)宽恕的文件后,伍德沃德把这段轶事写进了自己的论文。他的教授给他的论文打了不及格,并解释说没有人能光着脚在雪地里站这么久而不冻僵。

这位教授说:“国王的神圣权利并没有延伸到推翻自然法则和常识。”

根据亨利国王访问卡诺萨的无穷无尽文件,ChatGPT很可能会犯同样的错误,而你必须扮演教授的角色。

当然,这些机器人将改变世界。但你有责任警惕这些系统的言行,编辑它们提供给你的信息,以怀疑的态度对待你在网上看到的一切。研究人员知道如何赋予这些系统广泛的技能,但他们还不知道如何赋予它们理性、常识或对真的感知。

这一切仍然取决于你!

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。