谁来为人工智能的行为负责?--读《机器人现代法则》

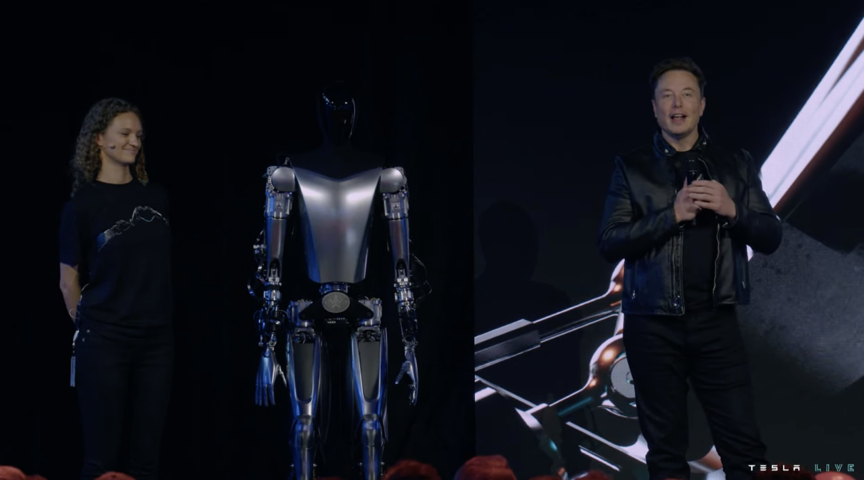

如果人工智能造成了伤害,该由谁来负责?近年来,人工智能领域的技术创新频频受到资本市场青睐,也日渐走进大众视野,成为人们热议的话题之一。然而,人工智能兴起的意义远远超过了技术本身,因其能够在无须人类干预的情况下作出决策的特性,人工智能对全球经济、政府和社会各个领域正在产生深远影响,其所带来的潜在变化,可能会比智人进化以来的任何发展都更具革命性和广泛性。而今,人们不得不郑重探讨,对这些近似人类却非人类的智能体,应当如何规范它们的行为、权利和责任?

1942年,科幻小说家艾萨克·阿西莫夫在其科幻小说中首次提出机器人法则,又称机器人三定律——第一定律:机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不顾;第二定律:机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外;第三定律:机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存。

不同于旧日的科学幻想,如今人工智能技术已开始萌芽,并且迅速发展。作者将本书命名为《机器人现代法则》,一定程度上也凸显了对人工智能这一“现代”课题的现实关切。作者将深思熟虑和真知灼见注于笔端,对人工智能发展的意义和应当采取的应对计划进行了深入分析,为人们如何在思想上和社会结构上做好准备提供了启示。

能否“成年”:

人工智能的独特性和立法需求

早在人工智能一词被提出之前,神话传说中已有用无生命材料创造智慧生命的故事,可见人类关于人工智能的想象从未止歇。但即使在人工智能概念大火的今天,对于什么是人工智能,仍然众说纷纭,未能达成一致的通用定义。作者列举了大量人工智能的应用场景,如智能手机上安装的各种应用程序,包括基于收听历史的音乐库推荐、用于消息传递的预测文本建议,还有虚拟个人助理、自动驾驶汽车、可创作音乐或半抽象艺术作品的程序等各类技术,以说明其独特性。在此基础上,作者对人工智能作出适用于法律解释的定义:人工智能是非自然实体通过评估作出选择的能力。简而言之,就是能够自主决策的能力。

仅从目前看来,接近人类能力水平的广义人工智能尚不存在,但毫无疑问,当人工智能达到足以与人类智能相媲美的奇点,甚至超越人类智能,世界将发生翻天覆地的变化。基于对人工智能可能成长为超级智能体的预想,三种声音涌现了出来。

乐观主义者强调好处并淡化任何危险,悲观主义者认为发展人工智能是冒着“召唤恶魔”的风险,实用主义者承认其好处和潜在灾难,主张谨慎发展人工智能并控制风险。斯蒂芬·霍金用一句话总结了人们的矛盾心理:人工智能可能是发生在人类身上最好同时也是最糟糕的事情。

谁也无法预测超级智能何时诞生,不仅如此,人工智能带来改变的确切性和时间,在很大程度上都还是一种推测。在人类社会中,到了一定年龄或智力达到一定水平,人类将作为独立的个体对自己的行为负责。而人工智能成长到一定程度,是否也应到达法律上的“成年年龄”,承担相应的责任和权利?这一前所未有的法律现象,影响着从今时今日直至奇点到来以后,人类与人工智能如何互相适应和共存的重大命题。

作者提出,当法律是一种无声的背景时,它才是最有效的。我们需要人工智能领域的法律规则,以让各方在公平和可预期的氛围中相互交往,更好地携手走向未来,因为只有及早着手,才能尽可能以连贯、稳定和合法的方式,为解决人工智能带来的一系列问题做好准备。

应否“成人”:

人工智能的责任、权利和法律人格

几千年来,法律制度以人类为主体,也以人类社会的共同福祉为目的,保障着社会秩序、民众安宁和商业繁荣。人工智能的出现提出了新问题,即如何将目前以人类决策作为前提条件的法律和伦理,适用于能够自主决策的人工智能,如何根据需要作出一些制度设计上的优化,以在人工智能造成损害时,依据法律机制确定由谁负责?作者在书中以相关法则和典型案例对此逐一进行了分析探讨。

首先,在既有的法律框架内,可否通过调整某些责任规则,来包容人工智能产生的问题?作者在书中逐一分析了过失责任、产品责任、替代责任,以及在无过错事故赔偿计划、合同和保险等机制中,可适用于人工智能的法条和案例,并深入剖析了采用不同责任体系的优缺点。在此基础上,作者得出结论,现行法律可以而且将在短期内继续以上述方式确定人工智能的责任,但是我们不应止步于此,还可以用更激进的方式调整人与人工智能的关系。

其次,更激进的方式涉及一个问题:可否赋予人工智能权利?这个问题可能难以被人们理解和接受,但事实上,不仅类似的动物权利,连人权本身,也是经历了漫长的过程才成为社会共识,我们不应预设立场,而应该思考赋予机器人权利的理由是否充分。作者旁征博引,归纳了痛苦论、同情论、价值与人性论、后人文主义论等四个方面论点。无论是基于机器人能感知痛苦的想法,基于广泛的同理心,基于人工智能与人类相互尊重的价值利益,还是基于人与人工智能未来可能的结合,对赋予人工智能权利,作者总体持肯定态度。

最后,如果认可人工智能的道德权利,我们是否应该像赋予公司法人资格一样,赋予人工智能法律人格?对此,作者认为,这样做可以维护法律体系的完整性,可以在出现真正的自主机器人后填补责任鸿沟,可以鼓励创新和促进经济增长,可以让知识产权在人机之间进行共享,可以为人工智能提供遵守某些规则的动机。

但是,赋予法律人格并不意味着将人工智能视为人类,也不能让人类放弃对人工智能的所有责任。例如,对有人试图利用人工智能的独立人格作恶,并逃避惩罚的情形,可以仿效公司法中“揭开公司面纱”的制度,直接将责任归咎于肇事之人。

可否“成全”:

人工智能的监管和控制

在人工智能产业蓬勃发展的今天,有些人工智能受到规制,有的并未受到约束。若要为人工智能设计和实施量身定制的新法律,需要解决的首要问题就是,规则由谁来定?

鉴于人工智能是一项日益强大且具有潜在危险的技术,作者建议应当设立全球性的监管机构,进行跨文化跨边界的合作,以负责任的方式发展人工智能。通过制定适用于任何地区的统一标准和原则,使人工智能的发展在一个有效和可预测的环境中运行,从而使所有国家和地区都能从中受益。

国际组织有一系列在尊重国家主权的同时维持监管效力的措施,包括条例、指令、决定、建议、指南等,也可以通过采用示范法、建立国际人工智能法律学院,来促进有关法则知识和技能的发展与传播。以国际经合组织为例,其《跨国企业准则》作为各国政府向跨国企业提出的建议,仅是一系列自愿性的原则和标准,缺乏具体的惩罚措施,然而点名羞辱以及促成各方之间的对话仍在很大程度上取得了成效。这启示我们自利利他主义及非约束性的规则与规范体系,能够渐进性地形塑有关行为。在各国尚未就如何管理人工智能问题达成明确立场的当下,我们仍有机会来创建新的法律基础和共同语言,国家、地区和超国家组织都应当在制定明确有效的人工智能监管政策方面发挥协调作用。

在具体的规则中,需要重点考量的主体是人工智能的创建者,即设计、规划、操作人工智能的人和人工智能本身。对人工智能的创建者,可以用机器人伦理路线图、人工智能设计指南等作为规制方案,一些较为常见的主题包括:明确谁对人工智能造成的损害承担责任,保证设计的安全性、透明性,要求人工智能与人类价值观保持一致等。对人工智能,需要教给他们有效的价值观,这就要求在创建和矫正人工智能时,能更好地理解和应用一系列规范,包括说明其是否具有人工智能性能的识别法则、向人类阐明其推理的解释法则、改进不公正的输入和过程的偏见法则、规定可以做什么和不能做什么的限制法则和关闭人工智能的死亡开关设置等。

纵览全书,关于人工智能的理论和实践问题,作者明智地提出了一系列选项并进行了利弊分析,但并不认为有任何快捷简单的答案。为人工智能的设计和使用设定并实施法律和伦理约束,需要政府、工业界、学术界、利益相关方和公民都参与其中,共同应对。所有这些群体都应共同致力于解决人工智能引发的各类问题,同时也使自己受到监管,从而创造一种负责任的人工智能应用文化。为机器人制定规则无疑是一种挑战,但作者用贯穿全书的现实讨论发出呼吁,只要我们愿意努力,解决问题的工具就在我们手上。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。