如果机器人背叛人类,违背四大定律,那么杀人机器人将走向战场

2029年,人类和智能机器人之间的一场战争打响.....

在开始陈述前,我们需要了解机器人定律。

第一定律:机器人不得伤害人类,或坐视人类受到伤害。

第二定律:除非违背第一法则,否则机器人必须服从人类的命令。

第三定律:在不违背第二及第二法则下,机器人必须保护自己。

此后,人们又添加了一条定律:机器人不得伤害人类种群,或因不作为使人类族群受到伤害。统称阿西莫夫定律。

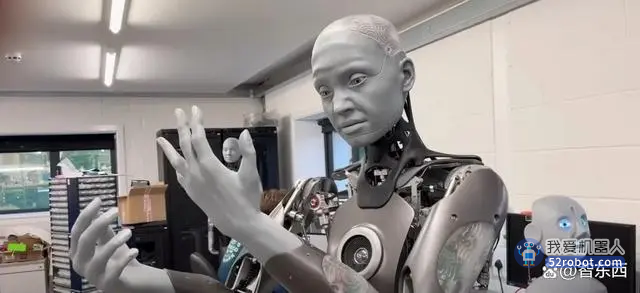

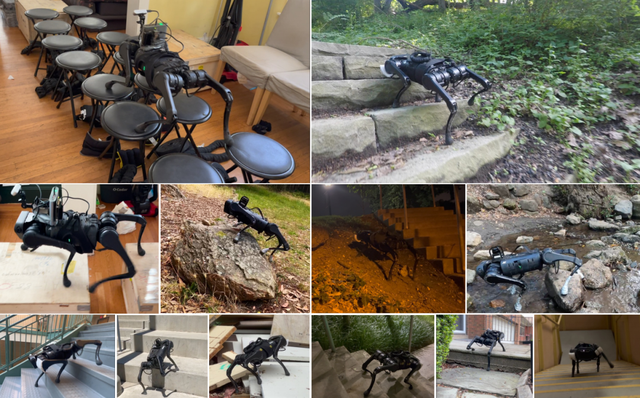

但是,现在的机器人拥有的功能和人们当初设想的不太一样,科技并没有让我们凭空创造出和我们一样的东西,我们并不能像对待奴隶一样命令指示它们。

目前没有机器人理解这4大定律。

不过随着人工智能时代的到来,我们讨论机械伦理问题的时机已经成熟。

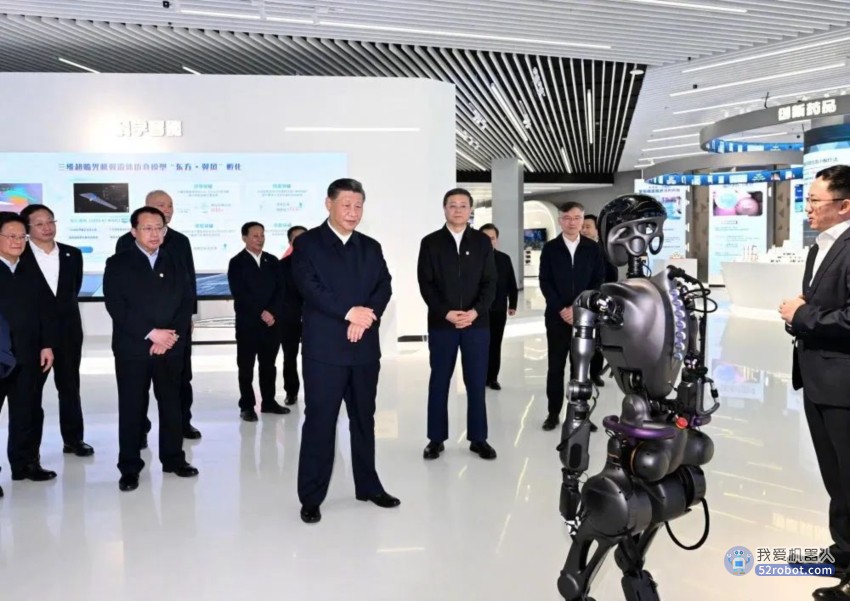

提出机器人伦理的著名科幻作家阿西莫夫认为,人类应该保留对机器人的控制权及防它们威胁人类。不过从另外的角度讲,机器人已经悄无声息地侵入到我们的生活,它们的形态与我们想象的千差万别。

很多军事系统通常由人类远程遥控,也就是它们并不会自行决定是否射击等。但是一些武器系统执行的打击任务需要快速反应和决断,因此它们被设定为无需人类确认就能自动攻击。

2013年,在联合国人权理事会的会议上,法国表示该国不拥有自主决定开火的机器人武器,也不打算获得这种武器。

不过在联合国2013年发表的一份报告中,南非比勒陀利亚大学的法学教授海因斯认为:“自主杀人机器人已经在一些国家如美国英国等军方实验室诞生了。”

那么现在我们需要思考,我们是否希望在这条路上走下去?首先,现在采取任何措施都有些太迟,因为这些系统已经存在,第二,机器人终有一日会变得更为精准,它们会尊重平民和交战规则,而人类战士在这两面都不能完美地执行,换而言之,这些武器能让战争变得更纯粹。

反自主杀人机器也取得了不小的进展。一封发表在2015年7月的公开信得到了2万人左右的签名,签名者有人工智能领域专家,以及物理学家霍金,苹果公司联合创始人沃兹尼亚克等。这封公开信要求停止研发具有杀人能力的自助系统,并且表示这些系统可以被恐怖分子当作武器。

科学家们也表示今天的人类也面临着一个重要的抉择:开始一场人工智能军备竞赛,或者避免这样的局面。

如果机器人还背叛人类呢?

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。