人工智能很火:让“机器人具备意识”是行业曾经的禁忌用语!

编者按:尽管现在人工智能很火,比如 ChatGPT 的聊天水平几乎让人很难分辨对方是否机器,但很少有人会说现在的 AI 具备了通用人工智能能力,而“机器具备意识”在圈内更是禁忌。但是,现在有人正在打破这种禁忌,琢磨着如何让机器具备意识。

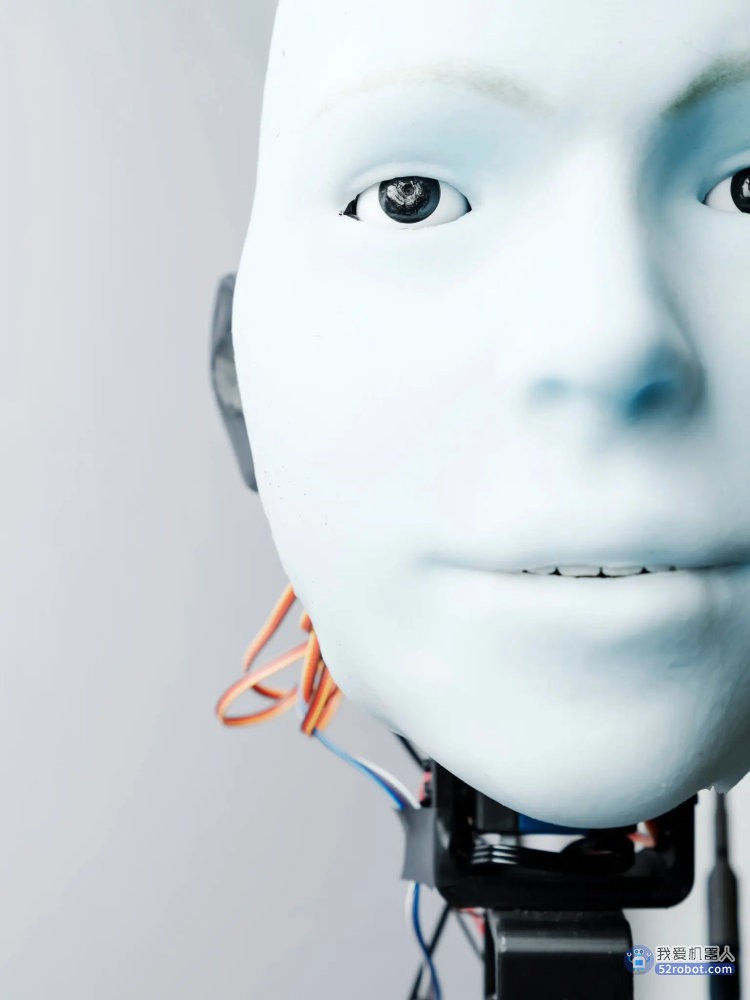

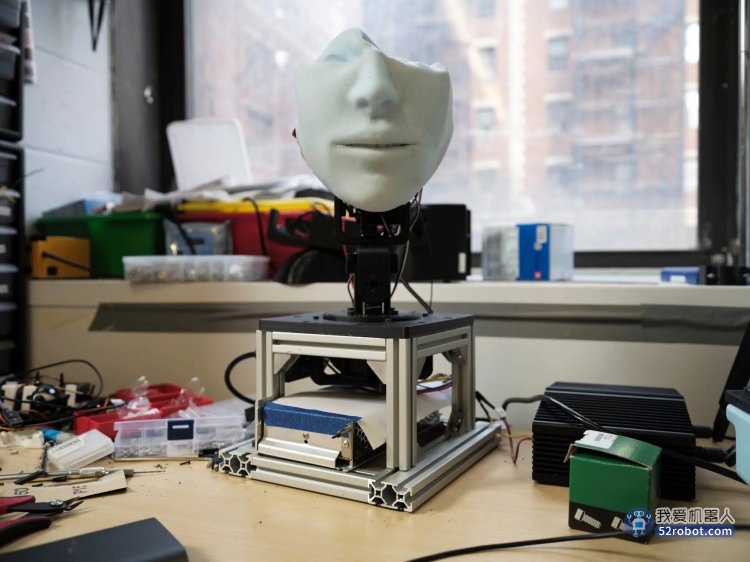

哥伦比亚大学Creative Machines Lab的博士生Yuhang Hu开发的一个机器人原型。这个实验室的目标是探索具备自我意识的机器人的可能性。

Hod Lipson 是哥伦比亚大学 Creative Machines Lab 的机械工程师,他职业生涯的大部分时间都在围着他所在行业的一些人所谓的禁忌词转。

去年 10 月,一个阳光明媚的早晨,这位出生于以色列的机器人专家正坐在他实验室的桌子旁做着自我介绍。 “这个话题属于禁忌,”他笑着说,门牙之间露出了一条缝隙:“谈论它几乎是被禁止的——‘不要讲那个令人不快的词;这样你拿不到终身教职的’——所以一开始我被迫掩饰自己,就好像它是别的东西一样。”

那是 2000 年代初期,当时 Lipson 还是康奈尔大学的助理教授。他正在努力创造机器,那种当它们自己的硬件出现问题,比如零件损坏或接线错误时,可以在没有程序员指导的情况下改变自身的行为,从而弥补造成的损害的机器人。这就像一只狗在事故中失去了一条腿之后,它可以教自己用不同的方式重新走路一样。

Lipson 认为,随着我们对机器的依赖越来越严重,这种内置的适应性也会变得越来越重要。机器人被用到外科手术、食品制造和运输等领域;机器的应用似乎无穷无尽,随着机器日益融入到我们的生活,机器在功能上出现任何错误都可能带来灾难。他说:“我们真的是在把我们的生命交给机器人。你肯定希望这些机器具有弹性。”

一种方法是从大自然中汲取灵感。动物,尤其是人类,善于适应变化。这种能力可能是数百万年进化而来的结果,因为对伤害和不断变化的环境做出反应的弹性通常会增加动物生存和繁殖的机会。Lipson 想知道是否可以在他的代码中复制这种自然选择,创造出一种通用形式的智能——这种智能可以不管身体是什么样的,也不管功能是什么,都可以了解自己的身体和功能。

Creative Machines Lab的主任Hod Lipson。他说:“这不仅仅是我们正在从事的又一个研究问题——这就是那个问题。”

如果存在做出来的可能的话,这种智能将是十分灵活和快速的。在紧张的情况下,它的表现会与人类一样好——甚至更好。随着机器学习变得越来越强大,这个目标似乎变得可以实现了。Lipson 赢得了终身职位,作为工程师的他,因为富有创造力且抱负远大,名声也越来越大。因此,在过去几年的时间里,他开始阐述自己所从事这些工作的根本动机是什么。他开始大声说出那个词:他想创造出有意识的机器人。

他说:“这不仅仅是我们正在从事的又一个研究问题——这就是那个问题。这比治愈癌症还要重要。如果我们能创造出一台具有与人类同等意识的机器,我们所做的一切在它面前都将黯然失色。那台机器本身就可以治愈癌症。”

Creative Machines Lab 位于哥伦比亚大学 Seeley W. Mudd Building 的一楼,实验室被组织成一个个盒子。那个房间本身就是一个盒子,被四四方方的小隔间分割成四四方方的工作站。在这种秩序下,机器人和机器人的零件散落在四处。一张蓝色的脸从架子上方茫然地凝视着;一个绿色的蜘蛛状机器从放在地上的篮子里探出腿;一个精致的蜻蜓机器人在工作台上保持着平衡。这是机械大脑进化过程中的废物。

研究意识的第一个困难是,对于意识实际指的是什么并没有达成共识。很多模糊的概念都是这种情况,比方说自由、意义、爱和存在,但这个领域通常应该是留给哲学家的,这不应该是工程师的负担。有些人试图对意识进行分类,想通过指向大脑的功能或一些更形而上学的物质来解释意识,但这些努力很难说是结论性的,而且还会引出更多的问题。即便是对所谓的“现象意识”最广为流传的描述之一(哲学家托马斯·内格尔所言)——“当且仅当一个有机体具有作为那个有机体是什么样(对于那个有机体来说是什么样)的经验时”,它才具有有意识的心理状态——也可能让人感觉不甚明了。

对机器人专家和计算机科学家来说,直接去趟这趟浑水似乎不会有什么结果。但是,就像意大利巴勒莫大学的机器人专家 Antonio Chella 所说的那样,除非把意识纳入考虑范围,否则智能机器的功能“感觉就像缺少了什么” 。

实验室一角,里面堆满了不同阶段机器人项目的配件

求助于人类特征这件事可以追溯到 1955 年,那是人工智能研究刚开始的时候,在当时,达特茅斯学院的一群科学家提出来一个问题,那就是机器如何可以“解决现在留给人类的各种问题,并改善自己”。他们想对大脑的各种高级能力,比如语言、抽象思维和创造力等建模,然后将其部署到机器内。而意识似乎是其中许多能力的核心。

尝试用易于处理的输入和函数来呈现这个黏糊糊的意识是一项艰巨的任务,如果不是不可能的话。大多数机器人专家和工程师倾向于绕开哲学,形成他们自己的功能定义。麻省理工学院机械工程名誉教授 Thomas Sheridan 说,他认为意识可以简化为某个过程,而我们对大脑了解得越多,这个概念就会越清晰。他说:“一开始它带点宗教色彩,令人毛骨悚然,到最后变成了一种直截了当、客观的科学”。

【这样的观点并非机器人专家所独有。丹尼尔·丹尼特(Daniel Dennett)和帕特里夏·丘奇兰(Patricia Churchland)等哲学家以及神经科学家迈克尔·格拉齐亚诺(Michael Graziano)等人也提出了各种意识功能理论。】

Lipson 和 Creative Machines Lab 的成员都属于这一传统范畴。他说:“我需要某种完全可以做的、干的、不浪漫的东西,告诉我具体细节就行”。他确定了意识的一个实用标准:想象未来的自己的能力。

根据 Lipson 的说法,不同的意识类型,比如人类意识、章鱼意识以及老鼠意识之间存在着一个根本区别,那就是看一个实体想象自己的未来能想象多远。意识存在于一个连续统一体之中。这个连续体的一头是知道自己在世界的什么位置的有机体——也就是具备某种原始的自我意识的有机体。比这更高的是具备想象你的身体未来会在哪里的能力,而比后者更进一步的是具备想象你最终能想象什么的能力。

Lipson 说:“所以最终,这些机器能理解它们是什么,它们在想什么。这会引出情绪和其他东西。”不过目前,他补充说:“我们还在做蟑螂版的意识。”

坚持用功能理论定义意识有什么好处?好处是这让技术进步成为可能。

诞生自 Creative Machines Lab,具有自我意识的最早机器人之一是一个有四条铰链腿和一个在黑色躯体不同地方附着了传感器的机器。通过四处移动,并留意输入到传感器的信息是如何变化的,这个机器人就实现了对自己的类似简笔画的模拟。随着机器人继续四处游走,它开始利用机器学习算法来提高自己所建模型与实际的身体之间的契合度。机器人利用这个自我形象在模拟中探索出了一种前进的方法。然后,它把这个方法应用到自己的身体上;现在,它已经弄清楚了如何在没有被展示如何走路的情况下学会走路。

在该实验室工作的杜克大学机器人专家 Boyuan Chen 说,这是向前迈出的重要一步。他说:“根据我以前的经验,每当你训练机器人执行一项新功能的时候,你总会看到有人站在旁边”。

利用了外部摄像头、深度学习算法以及概率模型来认识世界的双关节机器人。Lipson博士说:“它已经有了自我的概念,一朵云”。

最近,Chen 和 Lipson 在 《Science Robotics》 杂志上发表了一篇论文。论文揭示了他们最新的自我意识机器,一个简单的双关节手臂,固定在桌子上。通过围绕着它设置的摄像头,机器人可以在移动的时候观察自己——Lipson 说:“就像躺在摇篮里的婴儿看着镜子里的自己”。一开始的时候,似乎它并不知道自己在空间的位置,但在几个小时的过程中,在强大的深度学习算法与概率模型的帮助下,它已经能够找到自己在这个世界的位置了。Lipson 说:“它已经有了自我的概念,一朵云”。

但是,它真的具备了意识了吗?

任何意识理论一旦陷进去都会有风险,会出现招致批评的可能性。当然,自我意识看起来是很重要,但难道意识就没有其他关键特征了吗?如果我们不觉得某个东西是有意识的,我们还能说它是有意识的吗?

Chella 认为没有语言就不可能存在意识,并且他一直在开发可以形成内心独白、自我推理和反思周围事物的机器人。他的一个机器人最近能够认出镜子中的自己,还通过了也许是最著名的动物自我意识测试。

机器人专家、Creative Machines Lab 的前成员 Joshua Bongard 认为,意识不仅包括认知和心理活动,也包括本质上的身体方面。

他开发了一种叫做 xenobot 的存在,这是一个完全由青蛙细胞组成的生物,细胞之间是链接到一起的,这样程序员就可以像控制机器一样控制它们。根据 Bongard 的说法,不仅仅人类和动物已经进化到了能适应周围环境并能相互互动的程度;我们的组织也为了促进这些功能而进化过了,而我们的细胞也为了促进我们的组织而进化过了。他说:“我们就是由智能机器制成的智能机器制成的智能机器,以此类推”。

2022 年夏天,大概在Lipson 和 Chen 发布他们的最新机器人的同时,一位谷歌工程师声称该公司改进版的聊天机器人 LaMDA 已具备意识,应该像对待小孩子一样对待它。这一说法遭到了质疑,主要是因为就像 Lipson 所指出的那样,该聊天机器人正在处理“为完成一项任务而编写的代码”。其他研究人员则说,它没有基础的意识结构,只有意识的幻觉。Lipson 补充说:“机器人没有自我意识。这有点像作弊。”

但在存在这么多分歧的情况下,什么才算作弊,又是谁说了算呢?

加州大学河滨分校哲学教授 Eric Schwitzgebel 曾撰写过有关人工意识的文章,他表示,这种普遍不确定性的问题在于,按照这种发展速度,在我们就意识的标准达成一致之前,人类可能就能开发出被很多人认为具备了意识的机器人。当发生这种情况时,机器人应该被授予权利吗?自由呢?是不是应该对该机器人进行编程,让它在为我们服务时感到快乐?它会被允许争取自己的权利吗?比如可以投票吗?

(此类问题支撑起了一整个科幻小说子流派,在阿西莫夫、石黑一雄等作家的书里面都能见到这样的题材,也给《西部世界》和《黑镜》等电视节目提供了灵感来源。)

围绕所谓的道德可考量性(moral considerability)问题是动物权利之争的核心。如果动物能感觉到疼痛,那为了吃它的肉而杀死动物是不是错误?如果动物不像人类那样体验事物,是否意味着我们可以利用它们来享受自己的乐趣?一种动物是否具有某些意识能力似乎经常会影响到它是否拥有某些权利,但对于哪些能力很重要,目前还没有达成共识。

Zhizhuo Zhang(左)与Ruibo Liu(右)两位研究生正在折腾机器人的机械臂。

面对这种不确定性,Schwitzgebel 主张采取他所谓的“排中的设计策略”。其想法是,我们应该只制造两种机器,一种是在道德上至关重要的机器,并且我们的态度必须是鲜明的。从某个特定角度来看,位于意识和物质灰色地带的任何事物都可能会造成严重伤害。

牛津大学人类未来研究所(Future for Humanity Institute)的哲学家 Robert Long 支持这种谨慎态度。大型研究实验室和公司的人工智能开发,他说给他的感觉是“正朝着一个不确定的未来疾驰,在这个未来里将充斥着各种未知和令人烦恼的问题,而我们尚未做好应对的准备”。比较出名的是创造可以消灭人类的超级智能机器的可能性;开发出被广泛认为具备意识的机器人会增加应对这些风险的难度。Long 说:“我宁愿生活在一个事物发展要缓慢得多的世界里,这样人们可以有更多的时间去思考该往这些机器里面放入什么”。

但谨慎的缺点是技术的发展较慢。Schwitzgebel 和Long 承认,这种更加深思熟虑的方法可能会阻碍更具弹性及实用性的人工智能的发展。而对于实验室里的科学家来说,这样的理论化会让人感觉抽象得令人沮丧。

在被问及创造具有与人类相似意识能力的机器人存在什么风险时,Chella 说:“我认为我们离这种风险还远”。Lipson 补充说:“我是有一些担心,但我认为好处大于风险。如果我们走上了一条越来越依赖技术的道路,那技术就需要变得更有弹性。”

他补充说:“然后人们就会狂妄自大到想要创造生命。这是终极挑战,就像登月一样。”但比这要令人印象深刻得多,他后来又说。

在 Creative Machines Lab 的一个工作站里,一个具有自我意识的机器人手臂开始移动。实验室的研究生 Yuhang Hu 启动了一个机械序列。目前机器人暂时还没有观察自己并建立自我模型——它只是随机移动,每秒钟扭曲或移动一次。如果说它可以具备意识的话,那它现在还没具备。

Lipson 往椅背上一靠,看着机器人对 Hu 说:“我们还得做另一件事,得让这个机器人通过碰撞来做出自己的模型。”

头发乱糟糟的 Hu 手托着下巴说: “是的,这很有趣”。

Lipson 说:“因为就算是盲人也能形成自己的形象。”

Hu 说:“你可以往上面放个盒子”。

Lipson 说:“对。必须有一个足够丰富的环境,一个游乐场。”

两位科学家坐在那里思考着,或者似乎在思考着,一边盯着桌子上继续移动的机器人。

Lipson 指出,他的实验室就是这么做研究的。研究人员会向内看,注意自身的某些元素——身体的自我意识、对周围环境的感觉、对他人的自我意识——然后尝试将这些元素放入到机器内。Lipson 说:“我想尽我所能推动这个领域。我希望机器人能够思考自己的身体,思考它的计划。”

从某种意义上来说,这是所有机器人练习里面最简单的一个,就像小学生用旧电子产品做的练习一样。如果你可以对一台退役的打印机来做这件事情的话,为什么就不能对自己的脑子做这件事情呢?即把它拆解,看看它是怎么工作的,然后试着重新做出来。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。